Home em foco Conversas “secretas” dos Beatles foram reveladas pela inteligência artificial

Por Redação Rádio Pampa | 6 de fevereiro de 2022

Em 1968, John Lennon cantava no Álbum Branco dos Beatles que todos tinham algo a esconder, exceto ele e o seu macaco. É quase uma verdade: assim como os seus três companheiros de banda, o vocalista também tinha coisas a esconder – principalmente dos fãs. Mas, agora, segredos que permaneceram guardados por 50 anos foram expostos por algoritmos de inteligência artificial (IA).

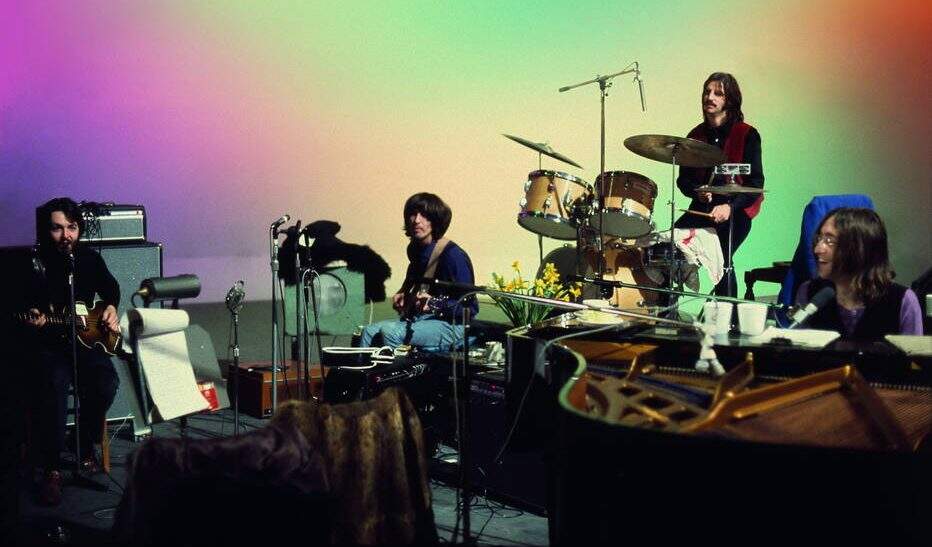

Nas série documental Get Back, disponível na Disney+, o diretor Peter Jackson restaurou o material captado em 1969 por Michael Lindsay-Hogg para o documentário Let It Be. As melhorias nas imagens trazem aos olhos cores vibrantes e causam impacto imediato. Mas é no novo áudio que partes das personalidades dos integrantes dos Beatles se descortinam, o que ajuda a construir a narrativa do filme.

O desafio era grande: quando Lindsay-Hogg registrou os ensaios dos Beatles nos estúdios Twickenham, ele espalhou microfones pelo espaço, que captavam tudo em uma única massa sonora: conversas, ruídos e sons de instrumentos – era quase como um show gravado pelo celular. Era impossível controlar todas essas fontes para trazer o que havia de mais interessante.

Era hora de recorrer à tecnologia. “Fizemos grandes avanços em áudio no documentário. Desenvolvemos um sistema de aprendizado de máquina (uma técnica de IA) para o qual ensinamos os sons de guitarra, baixo e voz. Assim, pudemos pegar a faixa em mono (com todos os sons gravados) e separar os instrumentos”, disse Jackson à revista Variety.

A técnica se chama unmixing, ou “desmixagem”. Ao contrário da “mixagem”, que tenta acomodar os vários elementos sonoros de uma gravação em uma única faixa, a desmixagem busca desmembrar os vários componentes de uma gravação. “É como se fosse possível pegar uma vitamina de frutas e isolar a banana, a maçã e o mamão”, explica Geraldo Ramos, fundador da startup Moises, especializada em algoritmos do tipo.

Revolução

O esforço para isolar instrumentos não é novo, mas foi só a partir da metade da década de 2000 que os experimentos aumentaram – um dos principais nomes da área está indiretamente ligado aos Beatles.

A partir dos anos 2010, James Clarke, principal engenheiro de software de Abbey Road, o estúdio onde a banda gravou vários dos seus discos, começou a experimentar com programas de controle de frequências, o que permitiu que ele remasterizasse o disco Live at the Hollywood Bowl, único disco ao vivo dos Beatles lançado oficialmente – a versão retrabalhada saiu em 2016.

Na mesma época do lançamento, acontecia o alvorecer da nova era da IA. Era natural que empresas, engenheiros de som e produtores buscassem nos algoritmos formas de aprimorar a desmixagem.

Para que uma máquina faça a desmixagem, ela precisa treinar com muitos exemplos dos sons que ela deve procurar numa gravação. Por isso, os algoritmos são expostos aos instrumentos isoladamente. No caso de análise focada em um artista específico, como dos Beatles, o ideal é que a máquina seja exposta aos mesmos modelos de amplificadores, guitarras, contrabaixos e peças de bateria usados pela banda.

Mesmo no caso da banda inglesa, que teoricamente tem fartos registros, o volume de informações pode ser insuficiente para treinar a IA. Nesses casos, é possível fazer algo chamado de data augmentation (aumento de dados, em português), que significa fazer pequenas alterações no pacote de dados original para retreinar o sistema. “Você pode pegar os mesmos instrumentos e alterar artificialmente em 10 semitons para cima e para baixo”, explica Ramos.

Outra saída para engordar o pacote de dados é fazer gravações atuais com instrumentos da época – pode parecer uma saída cara, afinal, poucos lugares têm vastos acervos de equipamentos antigos. Isso, porém, pode ser contornado digitalmente por meio de plugins (programas de computador) que emulam os timbres de instrumentos e amplificadores.

Apesar do cuidado com timbres e equipamentos, no princípio, o som era imagem. Os primeiros algoritmos usados na análise do áudio eram redes neurais convolucionais (CNN, na sigla em inglês). “As CNNs são muito boas para analisar imagens”, diz Anderson Soares, coordenador do Centro de Excelência em Inteligência Artificial da Universidade Federal de Goiás (UFG).

Isso significa que os sistemas analisavam o comportamento dos sons por meio de espectrogramas, representações visuais do que acontece nas frequências quando um som é emitido. A análise sonora de verdade só passou a ser feita mais recentemente por meio de outros tipos de algoritmos como LSTM (long shortterm memory) e Transformers – essa última considerada a técnica mais avançada de IA.